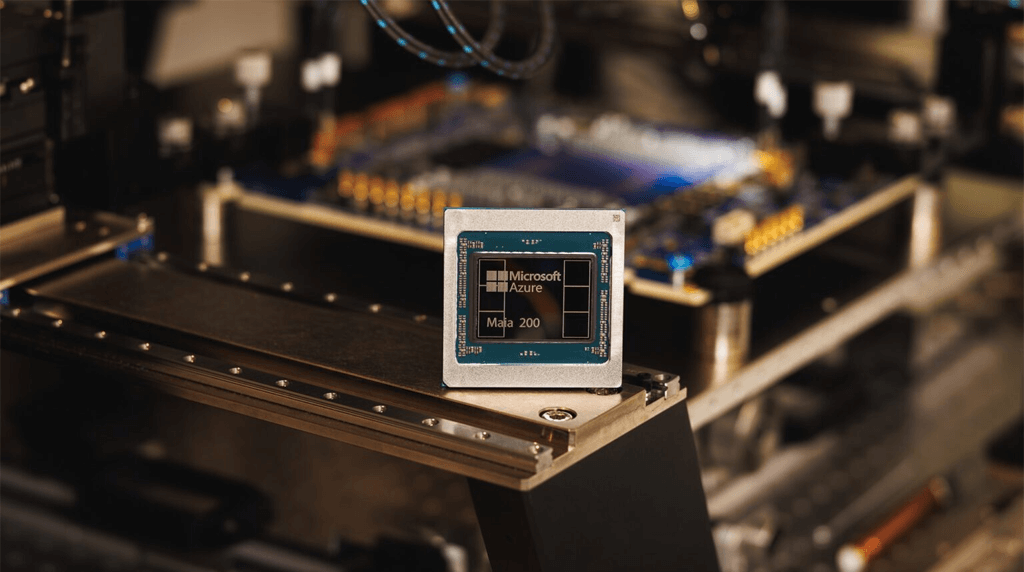

マイクロソフトは、Maia 200という新しいAIチップを発表しました。

NVIDIAへの依存を低減し、コスト効率を向上させることを目的としています。マイクロソフトはこれをAzureクラウドで活用し、一部タスクではAmazonやGoogleの競合チップを上回る性能を主張しています。

ポイント

- Maia 200は、AIモデルのトレーニングではなく推論(訓練済みモデルを実際のクエリに適用する段階)に最適化されたアクセラレータ

- マイクロソフトの前世代Maia 100からの進化版で、特定のワークロードではAmazonのTrainium 3世代比で3倍の性能向上を主張

- カスタムシリコンは、汎用GPU(NVIDIAのH100/Blackwellなど)と比べて電力効率が高く、Azureのデータセンター統合に適する

- 一方、NVIDIAのCUDAエコシステムほどの柔軟性や広範なソフトウェアサポートはないため、推論特化型として位置づけられる

全体として、AIインフラの「垂直統合」が進んでいて、ビッグテックが自社ワークロードに合わせたチップを設計するトレンド(Google TPU、Amazon Inferentia、Meta MTIAなど)を加速することになりそうです。

ニュース深掘り

ここからは、このニュースをビジネス面で深掘りしていきます。

戦略的・ビジネス的視点

マイクロソフトの今回のチップ開発における最大の動機は、コストコントロールとサプライチェーンリスク低減といえます。

AIブームでNVIDIAのGPU需要が爆発し、価格高騰・供給不足が発生しています。

そんな中、OpenAIのような大規模顧客向けに自社チップを使うことで、30%以上のコスト効率向上を実現可能とされていて、これはAzureの競争力を強化します。

将来的にMaia 200を外部顧客に開放すれば、新たな収益源にもなります。

一方、リスクもあります。自社チップ開発には巨額投資が必要で、性能が期待を下回ればNVIDIA依存が続く可能性があります。

実際、トレーニング分野ではまだNVIDIAの優位性が揺るぎません。

市場的・競争的視点

現在、NVIDIAのシェアは現在80-90%超ですが、Maia 200のような動きが続けば、価格競争が激化し、エンドユーザー(企業)にとってはコスト低下の恩恵が期待できます。

競合では、AmazonのTrainium/Inferentia、GoogleのTPU v5、さらには新興のGroqやCerebrasなどが台頭しています。

結果として、AIハードウェア市場は「NVIDIA一強」から「多極化」へ移行し、イノベーションが加速するでしょう。

ただし、短期的にNVIDIAの株価に悪影響を与える可能性は低いです。マイクロソフト自身もトレーニングではNVIDIAチップを大量購入しており、完全な「脱NVIDIA」ではないからです。

今後、Maia200の性能を実際に確認しながら、投資対効果が見合い、使えそうであれば置き換えていく、と言う流れになりそうです。

倫理的・社会的視点

ビッグテックの垂直統合が進むと、チップ設計・製造の力が少数の巨大企業に集中し、新規参入障壁が高まるリスクがあります。

また、地政学的にはTSMC依存が続くため、サプライチェーン全体の脆弱性は解消されていません。

AI開発を行う企業では、ビジネスへの影響

自動運転や創薬、新素材開発など、さまざまな分野でAIを活用した研究開発が進んでいる状況で、AI開発を行なっている企業においては、良くも悪くもNVIDIAに依存していればよかったという状況が崩れてきています。

リソースの分散、多能化などを考えると、(コストを度外視すれば)NVIDIA一強の方が楽ではあるのですが、そうも言ってはいられません。

そこで、ここからは、この発表に対するAI開発を行う企業への影響を解説します。

インフラの多角化を急ぐ必要あり

NVIDIA一辺倒ではなく、Azure Maia、AWS Inferentia、Google TPUなど複数プロバイダーを評価した方が良いと思われます。

なぜなら、ワークロードに応じて最適な組み合わせを選ぶことで、コストを20-40%削減できる可能性があるからです。

長期契約の見直しを検討すべき

GPU供給不足が続く中、クラウドベンダーのカスタムチップ移行が進むと価格変動が起きやすいです。

1-2年単位でベンダー比較を行い、ロックインを避ける柔軟な契約を優先してください。

自社AI戦略の再検討

大企業であれば、カスタムチップやFPGAの導入を検討する価値があると思われます。

中小企業は、Maia 200のような推論特化チップが開放されたタイミングで、Azure移行を視野に入れてみると良いでしょう。

推論コストが支配的になる生成AI時代では、ここが最大の節約ポイントとなるはずです。

人材・スキル投資の必要性

AI開発を行なっている企業は、NVIDIA CUDA中心のスキルセットだけでなく、ONNXやTriton Inference Serverなどのマルチプラットフォームに対応した人材を確保してください。

チップ多様化時代に入ったとき、適応力が競争優位性になります。

リスクヘッジを忘れずに

地政学リスク(台湾有事など)を考慮し、複数リージョンのクラウド分散やオンプレミス回帰も選択肢に含めてビジネスを進めることが重要になるでしょう。