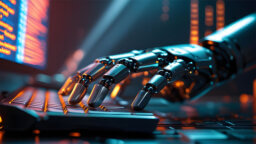

ロボットと言えば、通常はその仕様が明確に定義されていて、役割を高速にこなすことが重要な役割となるものだ。

しかし、ヒトの手のような腕を持ち、カメラで撮影した映像をもとに物体を認識することで、様々な作業を柔軟にできるロボットがあったらどうだろう。

例えば、たたまれていなタオルがそこにあれば自律的にそれを発見してたたみ、盛り付け前のサラダがあれば一人分を取り分けてくれるような。

タオルをたたむという行為と、サラダを盛り付けるという行為はそもそも動きがまるで違うが、それだけではない。画像認識をして、「たたんでいないタオルがあったら、たたむ」「盛り付けられていないサラダがあれば盛り付けなける」という、認識をしながら動作をするAIが搭載されているロボットアームならこれが可能になるのではないかと想像ができる。

こんな、頭脳をもったアンドロイドのような双腕ロボットを実現したのが、「マルチモーダルロボットアーム」のチームだ。

この取り組みは、早稲田大学 基幹理工学部表現工学科 尾形哲也教授のディープラーニングだけをつかったアルゴリズムで行う、「リカレント・ニューラルネットワーク」という研究をベースに、ベッコフオートメーション株式会社 代表取締役社長 川野 俊充氏、デンソーウェーブ 制御システム事業部 技術企画部 製品企画室室長 澤田洋祐氏、株式会社エクサウィザーズ 執行役員の浅谷学嗣氏がそれぞれの知見を持ち寄ることで実現している。

このプロジェクトの始まったきっかけは、尾形教授の、リカレントニューラルネットワークをロボットの行動生成に使うという論文発表を聞いた、ベッコフオートメーションの川野氏が「これは産業に利用できるのではないかと思った」ことなのだという。

メカもプログラムも同じなのに、学習内容を変えると動きが変わるという特徴があるこのロボットは、ディープラーニングで作った学習モデルを使っているのだが、タオルをたたむ時も、サラダを盛り付けるのも、プログラムは変えることなく、様々な動きを学習し動作している。

学習もVRを活用していて、動きをロボットに教えることができるのだ。実際にティーチングしている時は、あたかもロボットのコックピットに乗ったような気分なのだという。

野菜をつかむときの握力も学習しているため、野菜を壊すこともなく優しくつかむことができるのだ。

今回のVRでのティーチング(ロボットに学習をさせること)のポイントとしては、遠隔でも動かせることなのだが、実際にこのロボットに学習させることは決して簡単ではないということだ。

当初握力だけで野菜やタオルをつかむことができると思っていたが、初めに導入したイギリス製のロボットでは握力だけでモノをつかんでいることが試して分かった。実際には人間の指は指紋の摩擦でつかんでいることがわかり、ロボットにも指サックを付けたりして実験を重ねたのだということだ。

その後、義手の開発ベンチャーであるexiiiを紹介され、多肢ハンドが実現したのだという。この多肢ハンドは、6軸の自由度があり、親指も2軸の自由度、他の指も健がで引くことができる。サーボモータで握っているときの角度や触覚をも操作しているヒトやロボットに伝達することができるものなのだ。

今回こだわったポイントとして、「不定形物・軟体物の取り扱い」を行うというコンセプトがあると、デンソーウェーブの澤田氏は言う。

しかも、学習時には、直観的で、遠隔からもロボットを操作することで学習をすることができるということにもこだわった。例えば、海外にこのロボットが設置されていても日本で学習を行うことができるというのだ。

画像認識するためのカメラにはリコーのTHEATAが取り付けられていたが、当初は、Insta360 Proで試していたのだという。Insta360 Proは性能はよいのだが、生画像を送るのではなく、デバイス側でデータ処理を行ってからデータ配信を行う仕組みであるため、全体としては遅延が起きてしまい、使うことができなかったのだとベッコフオートメーションの川野氏は言う。

処理には、ベッコフオートメーションのGPUが搭載されたPCを使っているため、重いAIの処理も実現できるのだ。

複雑なAIの処理については、通常マシンを分けるものだが、「学習」と「推論」のプロセスをひとつの箱でできるようにしたいということで、リアルタイム処理ができるベッコフオートメーションコンピュータを活用し、一つのVisual Studioの環境で作ったのだという。

いくら設備が充実しても、頭脳となるAIによっては思った動作をすることができない。また、ハンドにセンサーがついていない状態での実験では、ハンド自体がつかむべき物体に対する死角を作ってしまうと、物体を落としたことにもロボットは気づくことができないのだ。

こういった物理的な問題だけではない。当初の実験では、ロボットに「リンゴをつかんで置く」という動作をしようとしたのだが、ディープラーニングによって予測される「未来の画像」ではリンゴをつかめているにもかかわらず、実際は落としているということも起きたのだ。

なぜこんなことが起きたのかというと、指が「つかんでいる」という感触を持つセンサーがついていなかったため、「落としている」ということを認識することができなかったのだ。

このままだと、ロボットはリンゴをつかんでいるつもりになっているので、リンゴを置こうとするが、その後、実際にはリンゴがないことをカメラが認識するため、そこではじめて落としたことに気づくということが起きたのだという。

また、AIはジョイントの角度など140次元の時系列の情報を学習しているのだという。学習の過程でロボットの腕の角度などが同じ状態になる場合がなんどもあるため、単純に学習すると腕が同じ角度になったときに、AIが次の動作を判断することができなくなるのだ。

そこで、時系列の情報を取得することでこれを回避したということだ。と、当時の苦労をエクサウィザーズの浅谷氏は振り返る。

ティーチングのフェーズでは、ヘッドマウントディスプレイにロボットが「見ている」ライブ映像を流すのだが、ライブ映像では奥行きがわからない。それではテーチングができないということで、ディープラーニングを使って、バーチャルな物体の奥行きを取得するということに成功したということだ。

ヘッドマウントディスプレイなどを使った学習における操作感については、操作者が腕を動かすと少し時間が遅れてロボットアームが動くということになる。見ているものと動作がずれるので違和感があるものだが、人間はだんだん慣れてくるため、操作がスムーズにできるようになるのだという。

この展示自体は昨年秋に行われていたのだが、その後、危険地域での作業や、ワンオペレーションで困っているところでつかえるのではないか、など、いろんな要望が上がってきているのだという。

今後、計算力をつければ、もっと腕が多いようなロボットも作れるし、高速動作するものなども実現可能だと川野氏は言う。

少し飛躍すると、こういった学習データを一般の方から募ることで、様々な動きを行うことができるロボットも実現可能となるだろう。

そもそもアカデミックな研究だった、それが、産業向けに実用的に作られたというのが面白い。カタログスペックだけではわからないトライアンドエラーを繰り返し、ここまで来たマルチモーダルロボットアームに、今後の進化に期待がかかる。

無料メルマガ会員に登録しませんか?

IoTNEWS代表

1973年生まれ。株式会社アールジーン代表取締役。

フジテレビ Live News α コメンテーター。J-WAVE TOKYO MORNING RADIO 記事解説。など。

大阪大学でニューロコンピューティングを学び、アクセンチュアなどのグローバルコンサルティングファームより現職。

著書に、「2時間でわかる図解IoTビジネス入門(あさ出版)」「顧客ともっとつながる(日経BP)」、YouTubeチャンネルに「小泉耕二の未来大学」がある。