企業においてLLM(大規模言語モデル)の活用が進む中、会議や接客といった音声コミュニケーションの現場における業務変革が期待されている。

しかし、従来の音声だけの分析では、対話の文脈や周囲の状況を完全に把握することは難しく、AIが人間に代わって適切な判断や行動をとる「AIエージェント」の実用化には課題があった。

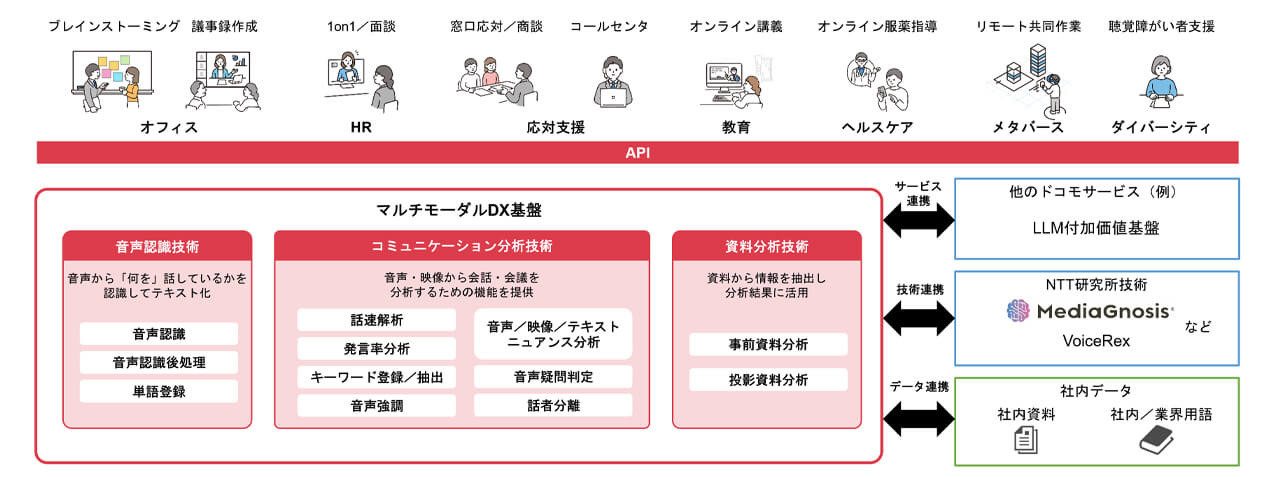

こうした中、株式会社NTTドコモは、従来の音声分析に加え、映像やテキストなどの多様な情報を統合的に分析する「マルチモーダルDX基盤」を開発したことを発表した。

同基盤は、人間がコミュニケーションを行う際と同様に、複数の種類の情報(マルチモーダル)を掛け合わせて状況を理解することができるというものだ。

NTTドコモはこれまで、音声認識や感情解析を行う「音声DX基盤」を展開してきたが、今回これを拡張し、NTTグループの次世代メディア処理AI「MediaGnosis」の技術を搭載したサーバである「SpeechRec Server」とも接続できるようにしたほか、LLMと連携させた形だ。

これにより、参加者の表情から読み取る「映像ニュアンス分析」や、提示されている資料の内容を理解する「資料分析」が可能となった。

音声、映像、テキストという異なる情報を共通のインターフェースで分析・統合することで、AIエージェントは「誰が、どのような表情で、何の資料を見ながら話しているか」という文脈まで深く理解できるようになる。

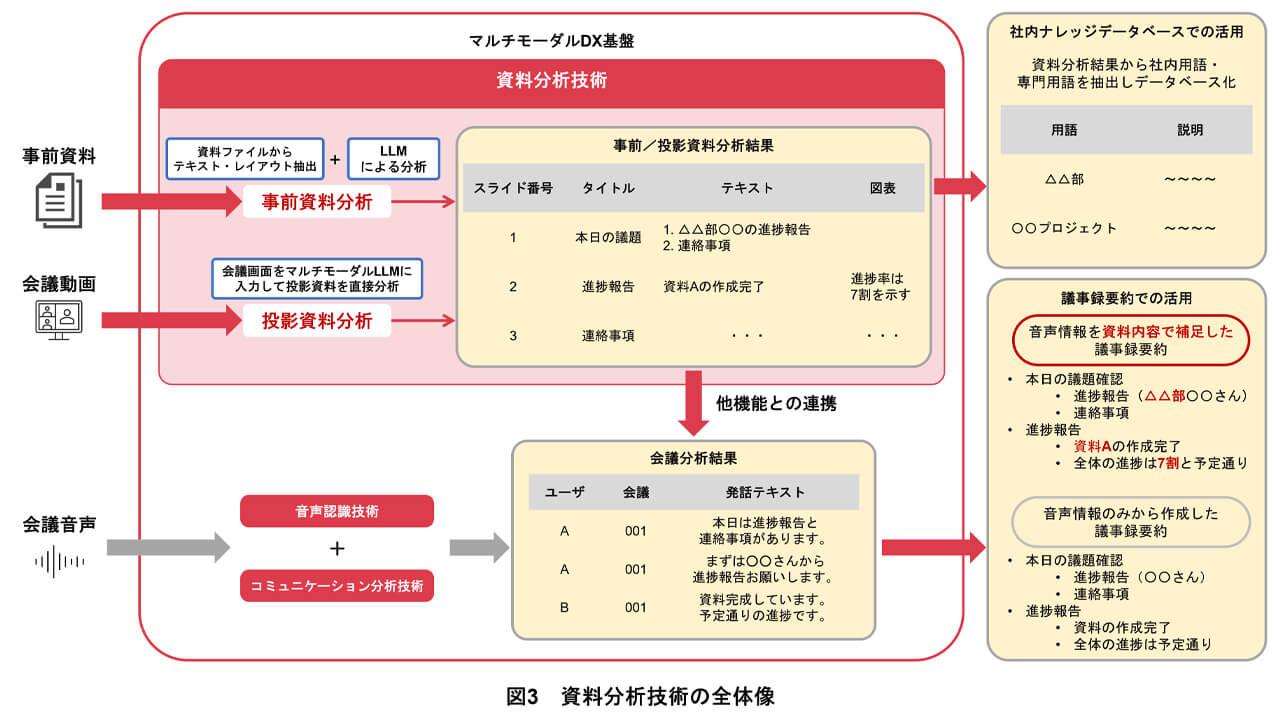

特に実務面での効果が期待できるのが、新たに追加された「資料分析」機能だ。これは、会議中に投影されている画面や事前に配布されたPDF資料をAIが読み取り、記載されている専門用語や文脈を解析する技術だ。

この情報を音声認識エンジンに連携させることで、社内用語や業界用語の誤変換を減らし、議事録の精度を向上させる。

また、会議中の議論と資料の内容を突き合わせることで、より具体的で正確な要約文をリアルタイムに生成することも可能となる。

さらにNTTドコモは、同基盤を活用した具体的なユースケースとして「会議支援エージェント」の開発を進めているとのことだ。

これは単なる記録係にとどまらず、会議の進行状況に合わせて必要な社内データを自律的に検索して提示したり、議論が停滞した際にアドバイスを行ったりするシステムだ。

同社は今後、分析できる情報の種類をさらに拡充し、企業の持つ社内データと掛け合わせることで、高度な判断が求められる接客や営業などの領域においても、AIエージェントによる業務の自律化・自動化を推進していく方針だ。

無料メルマガ会員に登録しませんか?

IoTに関する様々な情報を取材し、皆様にお届けいたします。