ソフトバンク株式会社は、AIデータセンタ向けのソフトウエアスタック「Infrinia AI Cloud OS」を開発したと発表した。

同ソリューションは、AIデータセンタの運用に必要な機能を包括的に提供し、構築・運用の自動化を実現する。

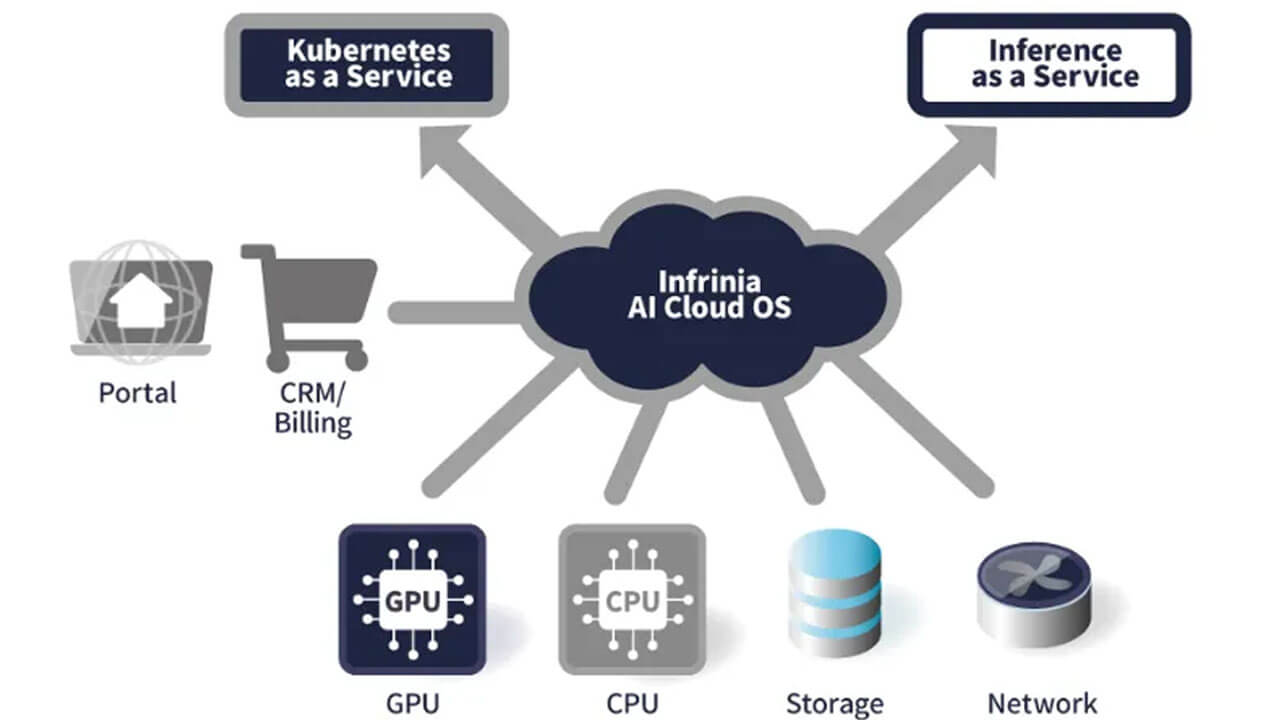

具体的には、マルチテナント環境に対応した「Kubernetes as a Service(KaaS)」と、大規模言語モデル(LLM)の推論機能をAPIとして提供する「Inference as a Service(Inf-aaS)」を、自社のGPUクラウドサービスの機能として構築することができる。

これにより、事業者はオーダーメイドでの開発に比べて、TCO(総所有コスト)や運用負荷の低減が見込まれている。

技術的な強みとしては、物理インフラの管理を高度に抽象化・自動化している点が挙げられる。

「NVIDIA GB200 NVL72」などの最先端GPU基盤において、BIOSやOS、GPUドライバー、ネットワーク設定などを自動化するほか、AIワークロードの要件に応じて物理接続(NVIDIA NVLink)とメモリーを動的かつ即座に再構成することが可能だ。

また、推論サービスにおいては、OpenAIと互換性のあるAPIを提供しており、既存のAIアプリケーションをそのまま移行できる利便性も確保している。

さらに、暗号化された通信によるテナント隔離機能や、顧客管理・請求システムと接続するためのAPIも備えており、商用サービスとしての展開を支援する。

ソフトバンクは今後、自社のGPUクラウドサービスへ同OSを導入する予定だ。

また、開発を担当した「Infriniaチーム」を通じて、海外のデータセンタやクラウド環境への展開も進め、グローバルでの普及を目指すとしている。

ソフトバンクの代表取締役 社長執行役員兼CEOの宮川潤一氏は、「AIインフラの進化は、物理的要素に加えて、それらを統合し柔軟に提供するソフトウエアが不可欠だ」と述べ、同OSを次世代AIインフラの中核に据える考えを示している。

無料メルマガ会員に登録しませんか?

IoTに関する様々な情報を取材し、皆様にお届けいたします。