昨今、自律的に業務を遂行する「エージェント型AI」の活用が進んでいるが、部外者がエージェントを操作して機密データを漏洩させたり、不正なアクションを実行させたりといった新たなセキュリティリスクも生まれている。

例えば、AIエージェントがどのデータにアクセス可能か、誰がそのエージェントを管理しているかが不明瞭な「シャドーAI」の問題や、外部からのプロンプトインジェクション攻撃によってエージェントが機密情報を漏洩させるリスクなどがある。

ガートナーの予測によれば、エージェントのID管理における課題が解決されない場合、2028年までにAIプロジェクトの50%が管理不能となり、停止に追い込まれる可能性があるのだという。

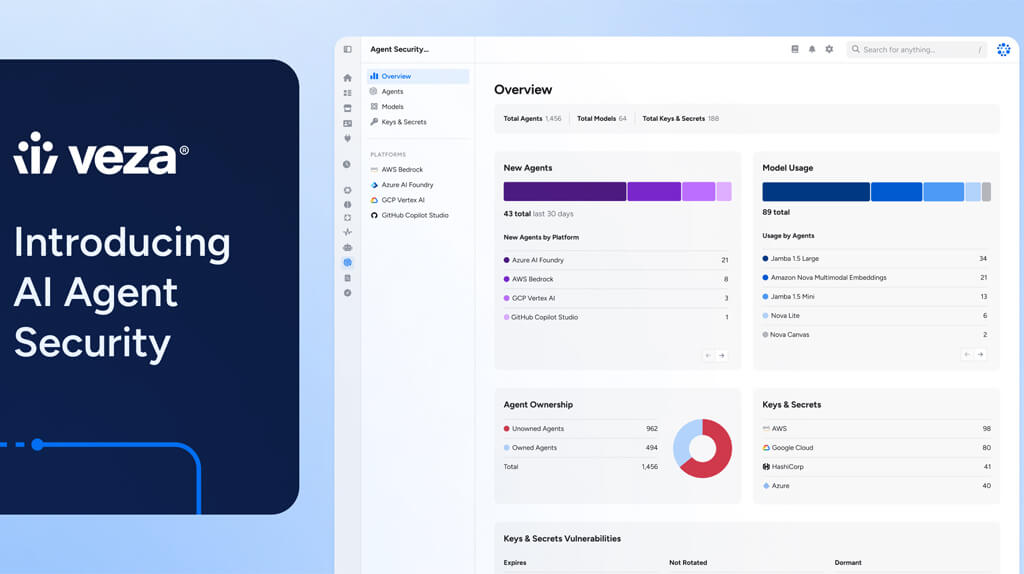

こうした課題を受け、アイデンティティ・セキュリティ領域の企業であるVezaは、企業規模でのAIエージェントの保護とガバナンスに特化した新ソリューション「AI Agent Security」の発表を2025年12月8日にした。

「AI Agent Security」は、同社独自のデータモデルである「Access Graph」を基盤としており、Microsoft Copilot Studio、Salesforce Agentforce、AWS Bedrock、Google Cloud Vertex AIといった主要なプラットフォーム上に存在するAIエージェントとMCPサーバを自動的に検出・可視化する。

そして、企業全体のエージェントIDを検出して分類し、AIエージェントがデータリソースやLLMモデルとどのように接続されているかを可視化する単一のプラットフォームを提供するものだ。

なお、これは監視とガバナンスに関するOWASPのLLMSecOps要件に準拠している。

同ソリューションの主な特徴は、AIエージェントに対し「最小権限の原則」を適用できる点だ。

AIエージェントは自律的に動作するため、過剰なアクセス権限を持つことは重大なリスクとなる。そこで同製品は、エージェントがアクセス可能な機密データやシステムリソースの範囲を特定し、過剰な権限を削除することで、万が一の侵害時の影響を最小限に抑える。

また、ガバナンスの観点からは、AIエージェントと人間の管理者を明確に紐付ける機能を提供する。

これにより、誰がエージェントの展開や管理に責任を持つかを明確化し、管理者のいないエージェントの発生を防ぐことが可能となる。

つまり、セキュリティ担当者は「環境内にどのようなAIエージェントが存在するか」「それらがどのデータやシステムにアクセスできるか」「どの人間がそのエージェントを制御できるか」といった問いに回答できるようになる。

VezaのCEOであるTarun Thakur氏は、「現状のエージェント型AIの状況は西部開拓時代(無法地帯)のようだ」と表現し、多くの経営層がAI導入を急ぐ一方で、エージェントが実際に何を行えるかについての可視性や制御が欠如していると指摘している。

無料メルマガ会員に登録しませんか?

IoTに関する様々な情報を取材し、皆様にお届けいたします。