内閣府総合科学技術・イノベーション会議が主導する革新的研究開発推進プログラム(ImPACT)タフ・ロボティクス・チャレンジ(プログラム・マネージャー:田所諭)の一環として、信州大学山崎公俊助教、アーノード・ソービ研究員、東北大学田所諭教授のグループは、被災地での捜索活動などに用いる遠隔操作ロボットで撮影した画像から、周囲に存在するものの種別や探索対象の発見を支援するための画像認識システムの開発に成功した。本システムは、ヘビ型ロボット、サイバー救助犬、ヒューマノイドロボットなど、災害環境で作業をおこなう様々なタイプのロボットへ搭載可能だ。

本システムのポイントは以下の4つである。

ポイント1. 不定形物が乱雑に存在する環境で撮影された映像から、どこに何の物体が写っているか、表面状態はどうか、を自動で識別。

ポイント2. 捜索対象(要救助者など)が存在しそうな領域の絞り込みに、効果を発揮。

ポイント3. 学習のために必要とするデータ量が少なく、初めての現場でもすぐに効果を発揮。

ポイント4. 操作者との対話を通して識別能力を向上・拡張していくことが可能。

<研究の背景と経緯>

熊本地震や阪神淡路大震災に代表される大規模地震災害では、倒壊した建物内に取り残された人の発見と救助が大きな課題である。信州大学山崎助教、アーノード研究員、東北大学田所教授を中心とするグループは、ImPACTタフ・ロボティクス・チャレンジの共同研究開発の一つのテーマとして、被災地での捜索活動を支援するための画像認識手法を研究している。その一環として、災害現場ですぐに利用できる捜索活動補助のための画像認識システムの開発をすすめてきた。被災木造家屋を模擬した評価試験フィールドや、森林環境、熊本地震での倒壊家屋で撮影した画像データなどに対して検証を行い、一定の性能が確認された。ImPACTタフ・ロボティクス・チャレンジで研究開発を進めるレスキューロボットは、1995年の阪神淡路大震災を契機に田所教授のグループのグループが提唱し、世界を牽引してきた研究分野である。田所教授は、災害ロボットの研究が世界的に高く評価され、IEEEFellow(米国電子技術協会IEEEの最高位メンバー資格)に昇格している。また、山崎助教のグループは布などの不定形物の認識・操作に関する研究で成果を上げてきており、平成28年度文部科学大臣若手科学者賞などを受賞している。今回の成果は、そこで培った技術を活用・発展させたものだ。

<研究成果の概要>

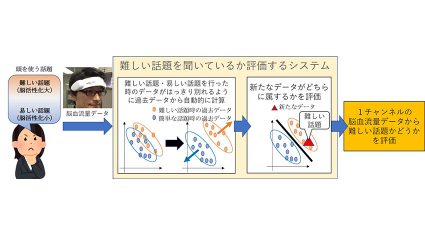

本システムは、倒壊家屋などの被災現場を撮影した映像を解析し、その結果を操作者に提示することで、捜索活動を支援する。被災地での捜索活動などにおいては、瓦礫の中から人や物体を発見するために、ロボットやビデオスコープで撮影した映像の解析が重要になる。近年、人工知能技術の発達により画像認識分野では相当な進歩が見られるが、その一方で、映像から意味のある情報を得るための機能(画像認識器)を構築する作業に手間と時間がかかり、被災現場のような乱雑な環境への素早い適用が困難だった。これは災害対応において特に大きな障害になる。田所教授のグループはこの課題に対し、映像から認識能力を得る処理(学習処理)を効率化することで、少ない事前情報から画像認識器を作り出す技術を開発した。この技術により、初めての被災現場でもすぐに効果を発揮でき、映像解析や重要情報の発見といった作業への利用が期待できる。さらに本開発では、瓦礫を構成している材質を推定する技術や、それらの表面状態(濡れているのか、土で汚れているのかなど)を数値化する技術も開発された。これらの技術により、崩れやすい場所や滑りやすい場所を発見しやすくなり、ロボットによる捜索活動における災害現場での崩落などの二次被害を防ぐことに役立つと考えられている。

ロボットに搭載したカメラから送られてくる映像は、それら特有の視点や狭い視野で得られることが多く、現場を正しく把握することは容易ではない。本システムでは、映りこんでいる物体の種類などを同定し強調表示することで、操作者の環境認識の支援が可能となっている。また、すでに現場に詳しい人から環境認識に関する指示を受けて、環境認識能力を短時間で獲得することも可能だ。

捜索支援:特定の対象の捜索をおこなう場合、(救助犬に匂いを嗅がせるように)その対象が映っている画像、または類似のものをシステムに事前に学習させることで、対象がカメラ映像に映ったときにアラートを鳴らしたり、記録を取ったりすることが可能となっている。それにより、遠隔操作中に対象の見逃しを防止する目的や、録画映像を通して重要情報を発見する目的への利用が可能。また、崩れやすい場所・滑りやすい場所を判断する作業、遠隔操作者が継続的には映像を閲覧できないような捜索状況での利用も有効と考えられる。

本成果は、以下の3つの研究開発成果から構成される。

(1)カメラから撮影をおこない、その映像に対して本技術により処理を行う。入力映像に対し、ひとまとまりとみなせる領域を検知し、検知領域を色付けて強調。検知領域が意味のあるものと判断できる場合、操作者はその領域にカテゴリ名を付ける。この作業により、本システムは対象領域を学習し、同じカテゴリに所属する可能性が高いと判断される画像領域を同じ色で強調するようになる。操作者は必要に応じて領域を修正することもできる。このようなカテゴリ名の付与および誤認識の修正作業を通して、現場の映像から迅速に認識能力を獲得させることができる。認識能力が十分に得られた後は、認識のみのモードでシステムを動作させることで、捜索活動・状況確認活動を続けることが可能である。

(2)木や草が乱雑に生えていたり、枯れ葉が堆積している森林環境の環境認識を行うには、乱雑なテクスチャ(模様)から有意なパターンを見つけ、種別をおこなうことが有効である。乱雑なテクスチャ状況下での環境認識を実現するため、田所教授のグループは、以下に示す2段階の認識処理を開発した。入力画像を等間隔に区切り、その区切り(グリッドと呼ぶ)ごとに種別(犬、地面、木々、木の幹など)をおこなうことで、画像をおおまかに分割する。その後、2段階目をおこないます。各グリッド内部の画素ひとつひとつに対して、種別(木の幹、葉、草、空など)を行う。原画像の風景が、細かく分割処理され、森林のような乱雑な環境下での環境認識が可能になる。

(3)被災した建物内部の映像の解析を行う場合、材質などの種別に加え、汚れた場所・濡れた場所の検出や、汚れ・濡れの程度の推定を適切に行うことで、現場に入って作業を行う人々の安全性向上につながる。しかし、建材や内装に利用する材質は、特徴的な模様が少なく、撮影画像からこれらの情報を得ることは容易ではない。瓦礫構成物の表面状態の記述と種別本研究開発では、この課題の解決に向けて画像から有意なテクスチャ情報を得るための方法を開発した。水や土をつけた建材等の画像から、材質等や表面状態の違いを適切に表現できる手法を開発した。入力画像をグリッドに分け、テクスチャの違いによって各グリッドを色分けを行う。表面状態に係らずブロック、木板、背景紙がテクスチャ情報に基づいて分類することが可能になった。

次ページ:技術について