TOP >

人工知能(AI) > TED、AIパイプライン高速化により言語処理や画像処理が短時間で可能な「TED AIインフラパッケージ」を販売開始

言語処理や画像処理の分野において、AIを使ったさまざまなサービスの利用が進んでいる。高精度なAIモデルを学習により作成し、学習済みAIモデルにて未知のデータを推論させることがAIサービスの運用となる。運用で新たに入手したデータは再学習に利用され、予測精度を高めていく。これは一般的なITサービスの開発/運用とは異なり、学習を繰り返すという一連の作業を運用していかなければならない。この一連の流れをAIパイプラインという。

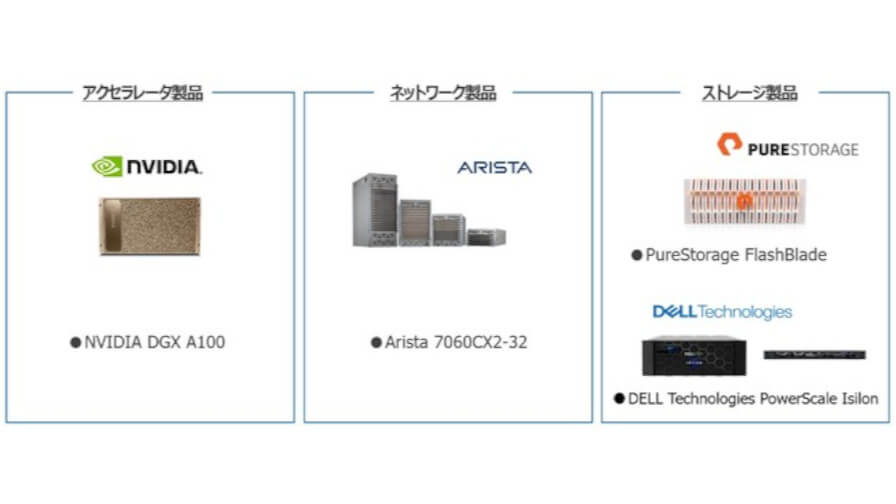

このAIパイプラインの効率化と処理速度を上げるには、高速なアクセラレータに加え、AIモデルの学習環境と推論(運用)環境を相互に接続できるよう、ネットワーク構成、データ共有構成など、AIパイプライン処理に特化したシステム構築が必要である。

東京エレクトロン デバイス株式会社社(以下、TED) は、より高精度にデータ学習したAIモデルの作成と持続可能なAIサービスを可能にするAIアクセラレータ・ストレージ・ネットワークの製品を一つにまとめたAIインフラパッケージ製品「TED AIインフラパッケージ(TAIP)」の販売を開始した。

同パッケージは、学習環境と推論環境を相互に接続する機能と高速なアクセラレータにより、AIパイプライン処理を短時間で可能にする。

パッケージ化された構成はTEDで検証し、実際のAIモデルを使って動作を検証済みのため、システム管理者は言語処理や画像処理の分野におけるAIを使ったさまざまなサービスを実行するための最適化されたAIインフラとしてすぐに利用できる。また、利用中のネットワーク・ストレージ環境とTAIPとの相互接続、ベンダーロックしない柔軟なシステム構成も利用可能だ。

無料メルマガ会員に登録しませんか?

膨大な記事を効率よくチェック!

IoTNEWSは、毎日10-20本の新着ニュースを公開しております。

また、デジタル社会に必要な視点を養う、DIGITIDEという特集コンテンツも毎日投稿しております。

そこで、週一回配信される、無料のメールマガジン会員になっていただくと、記事一覧やオリジナルコンテンツの情報が取得可能となります。

- DXに関する最新ニュース

- 曜日代わりのデジタル社会の潮流を知る『DIGITIDE』

- 実践を重要視する方に聞く、インタビュー記事

- 業務改革に必要なDX手法などDXノウハウ

など、多岐にわたるテーマが配信されております。

また、無料メルマガ会員になると、会員限定のコンテンツも読むことができます。

無料メールから、気になるテーマの記事だけをピックアップして読んでいただけます。

ぜひ、無料のメールマガジンを購読して、貴社の取り組みに役立ててください。

無料メルマガ会員登録

IoTに関する様々な情報を取材し、皆様にお届けいたします。

DX実践ノウハウ解説

BPMSで、業務改善にとどまらない、業務改革を行う方法

DX実践講座

業務プロセス改善のDXで使う「ECRS」とは、具体例や使い方を解説

業務改善のためのDX、5つの基本ステップ

DX人材の6つの役割と必要なスキル

DXを加速する、アジャイル型組織とは

攻めのDX、守りのDX

DX戦略を作るのに必須となる、5つのビジネスフレームワーク

DX時代の正しい事例の読み解き方(事例マニアはNG)

生成AI活用ガイド

カスタマーサポートの仕分けにAIを活用するメリットとは?Difyを活用したシステム構築ステップも紹介

営業日報のチェックを生成AIで効率化するには?Difyを活用したワークフロー自動化の検証も紹介

生成AIでプレゼン資料はどこまで作れるか? 「考える・作る・直す」に活用する具体的ステップを紹介

生成AIを顧客アンケートの設問設計・分析に活用するには?�ChatGPT・Geminiを活用して精度を検証してみた

生成AIで情報収集はどこまで自動化できる?ChatGPTやZapierを活用した自動化システム構築方法を解説

生成AIで営業データを使える知見に変えるには?業務別の生成AI活用方法と事例を紹介

OpenAIからAIエージェントを簡単につくれるノーコードツール「Agent Builder」が登場

営業ロープレにAIを活用する方法と課題とは?ChatGPTでできる実践法や成功事例も解説

生成AIで契約書の「リーガルチェック」 知らないと損するGoogleのGem活用術