IoTNews Global

もし、AIが複雑なゴール(目的)を達成する途中におかしな挙動をしたら、不快な動作や、危ない動作を起こす可能性がある。そこで、AI研究者が安全なAIシステムを開発するためには、人間による最終目的設定(ゴール機能の作成)を除くべきだという考え方がある。

今回、人工知能を研究する非営利団体で、代表をテスラのイーロン・マスクが務めるOpenAIは、Googleの関連会社であるDeepMindの安全チームと協力し、人間が望む結果を想定できるアルゴリズムを開発したというのだ。

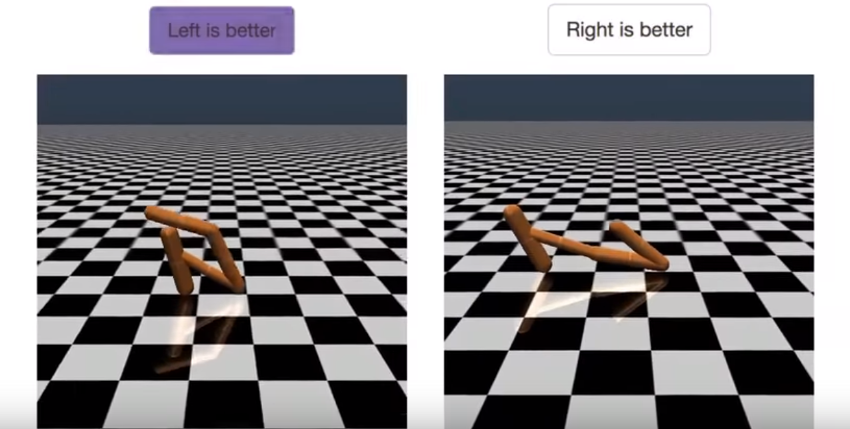

AIが二つの動作を表示し、人間がそれ中から望ましい結果に近い動作を選択することで、AIは人間の嗜好に基づいて学習し目的に達する。今回紹介されたアルゴリズムは900ビットという少量の人間フィードバックと強化学習によって「バク転」を学習したというものだ。

人間のフィードバックを使っている機械学習システムは従来もあったが、今回のシステムはもっと複雑なタスクにも適用するためにスケールアップされたところが新しいのだという。全体の学習プロセスは人間、AI エージェントによる目的の理解と強化学習という3ステップのフィードバックサイクルである。学習の仕組みは下記の通りだ。

1. AIエージェントがランダムな動作を始める。

2. 定期的にエージェントが異なる動作をしている二つの短い動画が評価をしている人間に表示され、人間が目的達成に近い動作の動画を選ぶ(この例は、バック転に近い動作ということだ)。

3. この繰り返しでAIが報酬を活用しながらタスクの最終目的のモデルを作り出し、最終目標を達成するために強化学習を使う。

4. 動作が改善していくとともに、エージェントは二つの軌道から選べることができない場合、人間に追加フィードバックを要請し、さらに目的の理解を深めていく。

評価者(フィードバックしている人)は、1時間以下の時間で、システムが70時間以上の経験を積み重ねた結果、同手法は高い効率性を発揮したという(シミュレーションスピードはリアルタイム動作より著しく速い)。ただし、同アルゴリズムの性能が評価者の正しい動作選択に強く依存しており、評価者がいいフィードバックを提供できなかったら学習結果も望むレベルに達せない可能性がある。

さらに、研究者が2時間をかけて、報酬機能を作成し、エージェントに同じバック転を学習した場合、今回のエージェントより動作が不安定だったという。つまり、手動で学習目的を設定するより、人間のフィードバックを使うほうが、もっと直感的かつ素早い目的指定ができるということだ。

今後、研究者は、人間から求められているフィードバック量の削減に力をいれるということだ。

無料メルマガ会員に登録しませんか?

IoTNEWS代表

1973年生まれ。株式会社アールジーン代表取締役。

フジテレビ Live News α コメンテーター。J-WAVE TOKYO MORNING RADIO 記事解説。など。

大阪大学でニューロコンピューティングを学び、アクセンチュアなどのグローバルコンサルティングファームより現職。

著書に、「2時間でわかる図解IoTビジネス入門(あさ出版)」「顧客ともっとつながる(日経BP)」、YouTubeチャンネルに「小泉耕二の未来大学」がある。