5月17-19日、グーグルがGoogle I/Oという開発者向けカンファレンスを開催しており、第一日目でグーグルCEOであるSundar Pichai氏が「Making AI work for everyone」というキーノートスピーチを講演した。

そのスピーチでコンピューティング業界は「モバイル―ファスト」から「AIファスト」という変化が起きていることを言及し、グーグルはこの変化を考慮し、独自の商品再考し、技術のさらなる自然でシームレスな相互作用を目指していると述べた。

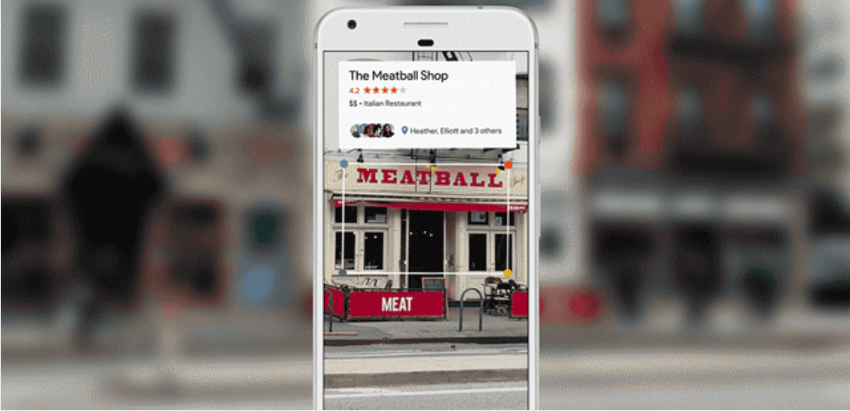

AI(画像認識)の発展で、カメラを使って検索することが可能になった。Google lensというサービスがコンピュータービジョン技術を使って、ユーザーが見ているものを理解し、それに基づいて行動をとる。例えば、画面に映っている花の種類を教えたり、店の看板でその店の評価を表示したりするなどの行動のことだ。

Google Lens はまずGoogle AssistantやGoogle Photosに統合され、後ほど他のグーグル商品にも導入される予定だ。

グーグルはVRやARのコア技術Tangoを数年間開発しており、今回TangoがVR技術のWorldSenseやスマートフォンAR用途で使われる。Tangoの技術によって機械がモーション感知、距離や現実世界での位置をセンシングできる。

また、グーグルがGoogle LensとTangoの技術のもとでビジュアル・ポジショニング・サービス(VPS)を開発している。同サービスは室内にあるデバイスの正確な位置を測定するため、大きいスーパーやモール、オフィスビルなどで活用可能である。

去年紹介されたDaydreamViewヘッドセットに対応しているスマートフォンの数が増えつつある。が、これからDaydream はスマートフォンやパソコンを使わない、いわゆるスタンドアロンVRヘッドセットにも対応するようになる。同ヘッドセットにはWorldSenseという技術が含まれており、回りの物に対してヘッドセットの位置が追跡されていることで、ユーザーの動きや位置が追跡可能になり、ヘッドセットを付けている時に定点からではなく、6自由度でVR鑑賞できる。

さらに、今年グーグルは推論や学習、ビッグデータ処理に最適化されたCloud TPUs (Tensor processing units)を発表し、それをGoogle Compute Engineに追加し、多数の企業や開発者に提供する予定である。Pichai氏はグーグルのすべてのAIに関するイニシアティブや実験をGoogle.aiでまとめて、誰でもが簡単にアクセスができるようにし、他の開発者、研究者や企業のAI活動を促進させる狙いがある。

また、AI研究者がグーグルのTensorFlow Research Cloudプログラムに応募し、受かったら1000の Cloud TPUが無料で利用できるようになる。各プロジェクトに利用可能なメモリや計算時間が与えられる。その代りに、グーグルは同プログラムで実施された研究のピアレビューされる形で公開やオープンソースコードの使用を求めている。研究を公開したくない企業がCloud TPU Alpha プログラムを使える。

Google Homeで使われているAssistantが現在ユーザーを声で区別ができるようになり、以前よりパーソナル化が実現された。Google Assistantがカレンダーにアポ入りやリマインド作成という便利な機能が追加されたの他、Iphoneでも使えるようになることが重要だ。さらに、Assistantがproactive notifications(積極的な通知)という機能を活用し、自ら会話を始め、ユーザーに役立ちそうな情報を伝える。

今年中にGoogle Homeが日本、オーストラリア、カナダ、フランス、とドイツで使用可能になり、市場シェアの獲得・拡大を狙う。Google HomeがAmazon Alexaと同様に、ハンズフリー通話機能を追加したという。

カンファレンスがまだ終わってないので、さらにどのような新技術が紹介されるか、興味深い。

Google Blog

無料メルマガ会員に登録しませんか?

IoTNEWS代表

1973年生まれ。株式会社アールジーン代表取締役。

フジテレビ Live News α コメンテーター。J-WAVE TOKYO MORNING RADIO 記事解説。など。

大阪大学でニューロコンピューティングを学び、アクセンチュアなどのグローバルコンサルティングファームより現職。

著書に、「2時間でわかる図解IoTビジネス入門(あさ出版)」「顧客ともっとつながる(日経BP)」、YouTubeチャンネルに「小泉耕二の未来大学」がある。