LLMをエッジで実行できれば、クラウドとの通信遅延を排したリアルタイム応答、機密データのオンプレミス処理によるセキュリティ向上、ネットワーク帯域の節約といったメリットが期待できる。

しかし、LLMはその巨大なモデルサイズと計算量から、従来は高性能なデータセンター環境での利用が主であり、消費電力や実装面積に制約のあるエッジデバイスへの展開は大きな技術的課題となっていた。

こうした中、Advantech Co., Ltd(以下、アドバンテック)は、NVIDIAのプラットフォームやGPUを活用したエッジAIコンピューティングプラットフォームを発表した。

今回発表されたプラットフォームは、ハードウェアとソフトウェア両面からLLMのエッジ実装を最適化している点が特徴だ。

具体的には、AI処理に最適化されたSoCである「NVIDIA Jetson」プラットフォームや、高性能な「NVIDIA RTX Ada Generation GPU」をハードウェアアクセラレータとして採用している。

そして、ソフトウェア面では、LLM推論を高速化・効率化する「NVIDIA TensorRT-LLM」最適化ソフトウェアライブラリ、そしてこれらを統合的に支える「NVIDIA フルスタック高速コンピューティング基盤」を活用している。

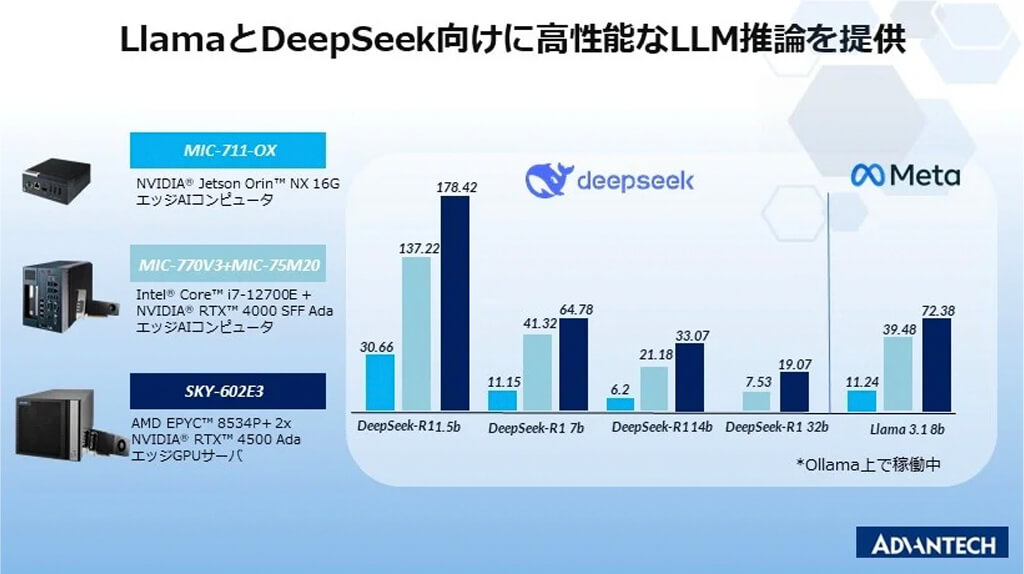

これにより、LlamaやDeepSeekといった主要なオープンソースLLMを、低遅延かつ電力効率よくエッジで実行可能にしている。

このエッジAIコンピューティングプラットフォームは、要求される性能や用途に応じて選択可能な3つのモデルを提供する。

一つ目は、組込み用途や省電力が求められる環境に適した「MIC-711-OX」だ。このモデルは、AI処理に最適化された「NVIDIA Jetson Orin NX 16GB」を搭載し、100 TOPS(INT8)のAI推論性能を実現しながら、低消費電力とコンパクトな筐体設計であるのが特徴だ。

省電力性と設置の容易さから、スマートファクトリーにおける品質管理や予知保全、店舗での対話AIキオスクなど、スペースや電力供給に制約のある環境でのリアルタイムAI処理に適している。

二つ目が、より高速で効率的なLLMの推論処理能力が求められる場合に適した「MIC-770V3 + MIC-75M20」だ。

このモデルは、「Intel Core i7プロセッサ」と「NVIDIA RTX 4000 SFF Ada Generation GPU」を組み合わせており、300 TOPS(INT8)という、「MIC-711-OX」の3倍の推論性能を提供する。

対象アプリケーションは、AIを用いたメールおよびドキュメント要約や、チャットボット・音声AIを活用したAIによる顧客サポート、コーディングおよび生産性向上ツールに対応したオンデバイスAI、サイバーセキュリティおよび不正検出AIが挙げられている。

そして三つ目が、特定分野向けのAIトレーニングを実現する「SKY-602E3」だ。サーバクラスの「AMD EPYCプロセッサ」と「NVIDIA RTX 4500 Ada Generation GPU」を2基搭載しており、1000 TOPS(INT8)を超える演算能力を提供する。

これにより、高度なLLM推論能力に加えて、エッジ環境でのAIモデル学習、特にLlamaのような基盤モデルのファインチューニングやドメインアダプテーションを可能にする。

対象アプリケーションは、財務・法務向けAIモデルにおけるカスタム法的文書分析やリスク評価、ヘルスケアAIアシスタントでの診断サポートや患者データ分析、AIを活用した情報管理や、AIベースのソフトウェア開発アシスタントが挙げられている。

無料メルマガ会員に登録しませんか?

IoTに関する様々な情報を取材し、皆様にお届けいたします。