文書には、テキストやアイコンや図表などの視覚要素が含まれており、こうした実世界の文書を読解し理解する技術の実現は、AI分野における課題の一つだ。

そこで日本電信電話株式会社(以下、NTT)は、大規模言語モデル(以下、LLM)によって文書を視覚情報も含めて理解する視覚読解技術を実現した。

この技術は、LLMの推論能力を活用し、視覚的に文書を理解するものだ。

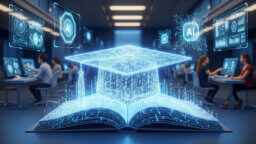

今回の研究では、文書画像をLLMの表現に変換可能な新たなアダプタ技術の開発および、多様な視覚読解タスクを対象とした指示遂行データセットの構築を行った。

アダプタ技術の開発では、画像中の文字および位置(座標)、画像の特徴を定量的に表現した画像情報、指示テキストを同一空間上にマッピングし、LLMに繋ぐ。

上図で示すように、学習時には、モデルパラメータの大部分を占めるLLMや画像エンコーダのパラメータを固定にし、アダプタのみを学習対象にすることで、パラメータ効率の良い学習を実現している。

また、この技術のアダプタでは、入力シーケンスを出力シーケンスに変換または変更するTransformer構造を採用し、学習可能なトークンに対して、相互注意では画像特徴との関係性を捉え、自己注意では指示テキストや画像中の文字および位置情報との関係性を捉える。

これにより、文書画像のマルチモーダルな特徴をLLMにとって解釈しやすい情報として獲得することができる。

一方、今回構築された指示遂行データセットでは、文書画像を知識源とし、質問応答、情報抽出、文書分類を始めとする12種類の視覚読解タスクを、人の指示を基に遂行する。

これらにより、LLMが文書の内容を視覚と言語を融合して理解し、任意のタスクを追加学習なしで遂行することが可能となった。

利用シーンとしては、文書を検索・スクリーニングを行う業務や、専門文献の読書補助など、オフィス作業や日常生活における人の認知が必要なシーンが挙げられている。

なお、この成果は、NTT版大規模言語モデル「tsuzumi」のアダプタ技術として採用・導入されているほか、LLMベースの視覚文書読解に関する具体的な方法論を示した論文として、2024年2月20日~2月27日にカナダ・バンクーバーで開催されたAI分野の国際会議「The 38th Annual AAAI Conference on Artificial Intelligence」において発表された。

今後NTTはこの技術を、視覚表現された文書を基に質問応答を行う技術やWeb検索など、産業上重要なサービスの発展に活用していくとしている。

無料メルマガ会員に登録しませんか?

IoTに関する様々な情報を取材し、皆様にお届けいたします。